友情提示

本站部分转载文章,皆来自互联网,仅供参考及分享,并不用于任何商业用途;版权归原作者所有,如涉及作品内容、版权和其他问题,请与本网联系,我们将在第一时间删除内容!

联系邮箱:1042463605@qq.com

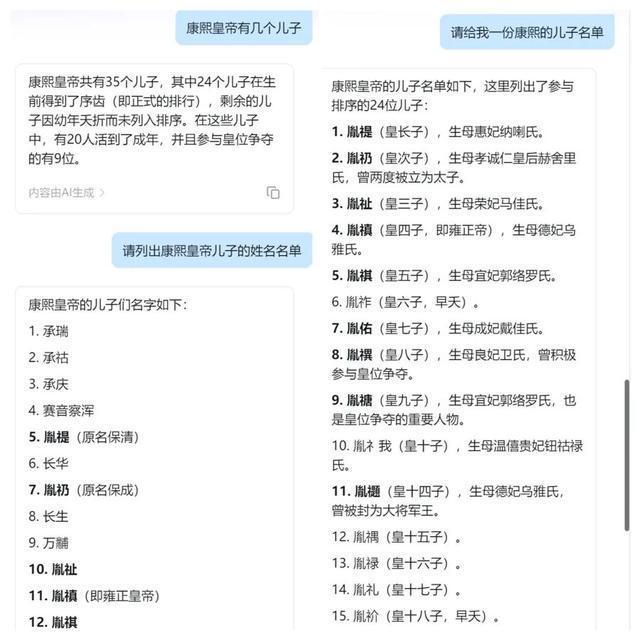

“人工智能回答康熙有几个儿子”引争议:丢什么都别丢脑子

3

0

相关文章

近七日浏览最多

最新文章

标签云

慈禧

影视剧

历史剧

历史人物

影视改编剧

折腰

小乔

高超

傻白甜

人生若如初见

改编

正剧

古装

大剧

电视剧

史同女

清明上河图密码

晚清

革命党

秋瑾

清朝

烈士

革命者

吴石

央视

于和伟

柳云龙

余皑磊

谍战剧

谍战新作

中国中央电视台

肖桂云

李前宽

历史大剧

优秀女演员奖

李大钊

龙平平

微短剧

平凡

浩然

张译

陈江河

人世间电视剧

骆玉珠

爱情故事

平凡的世界

谍战

天下同心

民主人士

毛泽东

宋庆龄

中国共产党

罪人

私货

伍秉鉴

林则徐

剧王

唐国强

蒋介石

习仲勋

刘志丹

革命史

解放战争

西北岁月

貂蝉

吕布

董卓

太平公主

宣昭皇帝

档案

黄金

蒋公

暗夜与黎明

道教

朱棣

中国历史

真武大帝

文鸯

卫瓘

晋朝

艺术

苏东坡

川剧

曹操

俗语

荀彧

郭嘉

袁绍

孔明

颜良

三国

易中天

四库全书

中国传统文化

乾隆

顺治帝

汉人

皇帝

千古一帝

顺治

康熙

刘备

丁原

卧龙

诸葛亮

孙策

长孙皇后

李世民

三国演义

纪晓岚

华为

任正非

核聚变

人工智能

技术革命

知名企业

天工

动作

马拉松

智能机器人

中国

黄仁勋

英伟达

颠覆性

超级计算机

科技公司

科技巨头

涨疯了

工业机器人

人形机器人

埃隆_马斯克

百度

陆奇

李彦宏

吴恩达

网络信息

OpenAI

deepseek

宇宙

翻译

詹国枢

大模型

云计算费用

科学

美国

美媒

教育优势

巴黎

欧盟

英国

法国

马克龙

星际之门

投资计划

算法

宣扬

复工

机器人

押注

分析师

麦格理

驱动力

开发成本

微软

推理

韩国

日本

冲绳县

日韩官方

典型问题

编程

应用程序

开源模型

模态

发布

视频生成模型

广东

kimi

gpu

美ai公司

英伟达芯片

英伟达h100

谷歌

私募

浙大

雷军

数学

外交部

拜登

联合国

国家安全

管制措施

商务部新闻发言人

清华

院长

钱颖一

中国教育

小米

知乎

卢伟冰

天才少女

深度学习

社会

本科

计算机

高校

机器学习

罗杰施密特

梦想照进现实

中国移动

通信

通信技术

ai

李世石

阿尔法狗

哈萨比斯

诺贝尔奖

alphago

教授

诺贝尔物理学奖

项立刚

孙凝晖

中科院

士绅

细品

李鸿章

袁世凯

胡宗宪

八旗子弟

清宫雷剧

雍正小蝶年羹尧

焦晃

八爷

刘和平

雍正王朝

审美

雍正

胤祥

胤禩

肖战

监正

汤若望

钦天监

司天监

宫斗

清穿

后宫

清宫剧

卿卿日常

王文昭

王逼宫

张廷玉

田文镜

八王爷

年妃

年氏

年羹尧

皇贵妃

皇位

八阿哥

佟佳隆科多

弘时

康乾

邬思道

生存法则

亲王

十三爷

太子

郑春华

佟国维

遗诏

胤禵

胤禛

九爷

高福

狗儿

李卫

叫花子

贵妃

后宫甄嬛传电视剧

巡抚

皇上

岳钟琪

江夏镇

吴山

山西

纪录片

东安沂山

乔引娣

穿帮镜头

胤礽

怡亲王

张廷璐