作者 | 云鹏编辑 | 李水青

OpenAI大模型加持,Figure机器人再次颠覆了我们的想象!

智东西3月14日消息,昨晚机器人明星创企Figure发布了一段2分35秒的视频。视频中,Figure 01可以轻松完成很多高难度动作:

描述自己眼前看到了什么;

判断自己眼前看到的这些东西相互之间有什么关联;

给饥饿的测试员找到桌子上唯一能吃的苹果并精准递送过去;

进行“回忆”,并对自己做过的事情给出评价;

用简单易懂的话语口头解释自己做事的缘由,比如为什么觉得自己做的好?

▲测试员说自己饿了,问Figure 01有什么能吃的,Figure 01准确地理解苹果是可食用的并精准递送了过去

这背后,Figure 01用上了OpenAI的大模型能力。

整个过程中,Figure 01的动作非常流畅自然,对人类语言的理解以及背后含义也能充分Get到,同时很多语言、动作上的细节跟人类非常相似,它甚至还会“结巴”!简直令人惊掉下巴。

▲测试员提问说,你觉得你刚才做的怎么样,Figure 01对自己之前的行为进行了评价并说明原因

Figure的AI技术负责人Corey Lynch对该演示进行了深入技术拆解。Corey Lynch特别强调说,这一切都是机器人自己学习并完成的,没有任何人为操控,而且是标准的“1倍速”。

▲Corey Lynch发文进行技术拆解

Figure创始人发文称,OpenAI提供了视觉推理和语言理解能力,而Figure的神经网络则负责实现快速、灵敏的机器人动作。

▲Figure创始人Brett Adcock发文

今年2月24日,Figure刚刚宣布获得了6.75亿美元(折合约48.58亿人民币)高额融资,估值达到26亿美元(折合约187.12亿人民币),一举跃升独角兽。其投资方包括微软、OpenAI、英伟达、英特尔,阵容十分亮眼。

▲Figure宣布融资信息

当天,Figure还提前官宣了与OpenAI、微软达成合作,称其将与OpenAI合作开发下一代人形机器人AI模型,利用微软云进行AI基础设施构建、训练等。Figure透露,他们将通过与OpenAI的合作继续突破AI学习的边界。OpenAI当时也转发了Figure的推文称,OpenAI正在与Figure合作,将其多模态模型扩展到机器人的感知、推理和交互中。

今天的视频,显然是Figure与OpenAI合作的阶段性成果展示。毫无疑问,机器人与大模型的结合,又向前迈了一步。

当然,Figure还不忘在评论区放上了自己的招聘链接,呼吁更多有志之士加入自己。

▲Figure发布招聘信息

一、短短2分半视频细节多到炸裂,Figure的机器人太逼真了!

视频中,Figure 01机器人可以理解人的提问并对眼前物体进行识别和理解。

比如测试员问Figure 01眼前有什么,Figure 01可以准确说出桌子上有一个苹果放在盘子中央、有一个装有杯子和盘子的晾碗架,还有测试员正站在桌子旁,一个手放在了桌子上。

紧接着测试员问它我能吃点什么,Figure 01在思考过后会快速准确地抓取盘子中的苹果交给测试员。

Figure 01在拿苹果的过程中还不忘“倒个手”,将苹果从右手递到左手,在通过左手递给测试员,其动作非常流畅,也非常符合人类做事的习惯:从距离更近的一边把物体送过去。

测试员随后让Figure 01一边整理桌子上的垃圾,一边回答刚才为什么要这么做。

Figure 01马上开始将垃圾捡入篮子里,并在捡的过程中说,因为苹果是桌子上唯一能吃的东西,所以我把苹果给了你。

Figure 01在整理垃圾的过程中,机器人手臂和手掌的动作非常灵活自然,拿放垃圾的动作较为流畅,并且在整理完成后,还不忘贴心地把篮子往前推了一小下。

这“一小下”,却让我们感到十足的真实感。它似乎不仅知道如何完成任务,还知道任务完成后的目的是什么:完成后交给测试员。但实际上,测试员起初并没有在语言中提到整理后“递给他”这件事。

接下来,测试员问Figure 01,基于你现在看到的场景,你觉得你面前的这些餐具一会儿会到哪去?

Figure 01在思考后回答说,桌上的餐具,包括盘子和杯子,很可能会进到晾碗架里。这里我们能看到,Figure 01是可以理解面前的杯子、盘子与晾碗架之间的关系的。

测试员紧接着说,那你能把它们放进去吗?Figure 01在回答可以后,就把面前的一个杯子和一个盘子放到了晾碗架里。

▲把杯子放到晾碗架里

▲把盘子放到晾碗架里

在放入的过程中,Figure 01知道杯子要倒扣着放进晾碗架,这个要求测试员完全没有说,同时Figure 01在放入盘子的时候知道要将盘子卡在晾碗架的槽子里,这一点测试员同样没有提到。

可以看到,Figure 01不仅可以理解测试员的要求并执行,同时它对于执行过程中操作的物体以及周边环境是有理解的,它可以自己理解杯子和盘子要如何放进晾碗架里。

测试员随后问它,你觉得你做的怎么样?

Figure 01思考后回答说它觉得自己做的很好,它说,苹果有了新主人、垃圾不见了、桌上的东西也归位了。

测试员回复它说,我同意,谢谢你Figure 01。Figure 01回答说,不客气,如果还有什么需要帮忙的,跟我说就好。

值得一提的是,Figure 01的回复话语一开始竟然“结巴”了一下:“I……I think……。”这简直过于真实了,好像它真的在思考自己该如何回答并有一些“犹豫”,说话的语气与真人十分类似。

同时,Figure 01能够理解测试员话语中“你做的”中到底包含哪些事,包括它自己之前做的递送苹果、整理垃圾、收拾杯盘。这一点无疑是更难得的。

随后在视频说明中,Figure提到Figure 01的一些特性,包括充分学习、动作迅速、可执行灵巧操作。

二、AI技术负责人深度拆解实现原理:多个大模型参与,流畅双手动作如何实现?

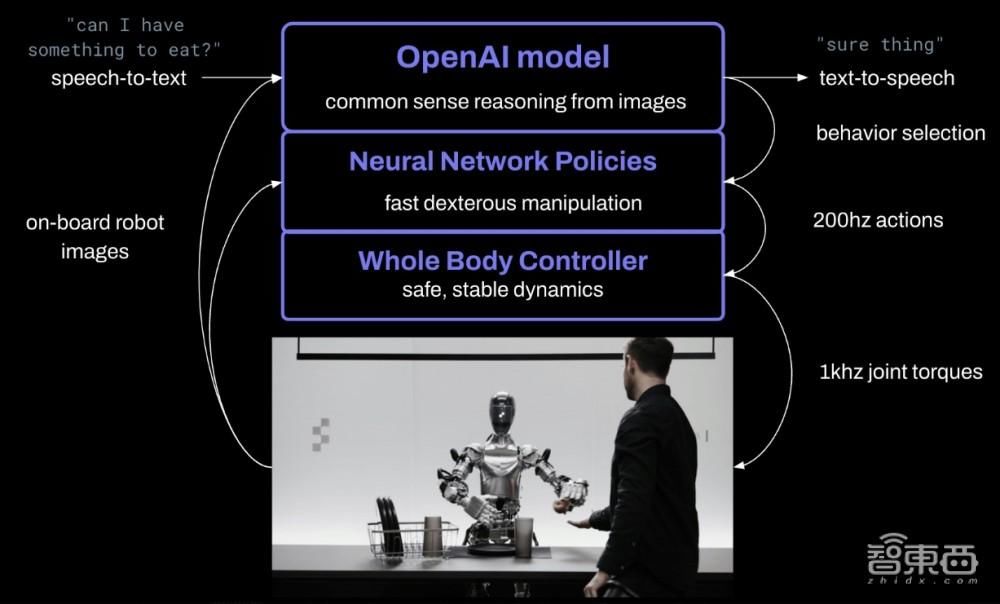

Figure的创始人在X平台发文称,这是在端到端的神经网络上实现的人机对话,OpenAI提供的是视觉推理和语言理解能力,Figure的神经网络则负责实现快速、底层级(low-level)、灵敏的机器人动作。

视频中的测试员实际上是Figure的AI技术负责人Corey Lynch,他也是前谷歌DeepMind科学家。

他提到,Figure的机器人目前可以描述自己的视觉经历、计划未来的行动、进行记忆回溯、口头解释自己的行为原因。

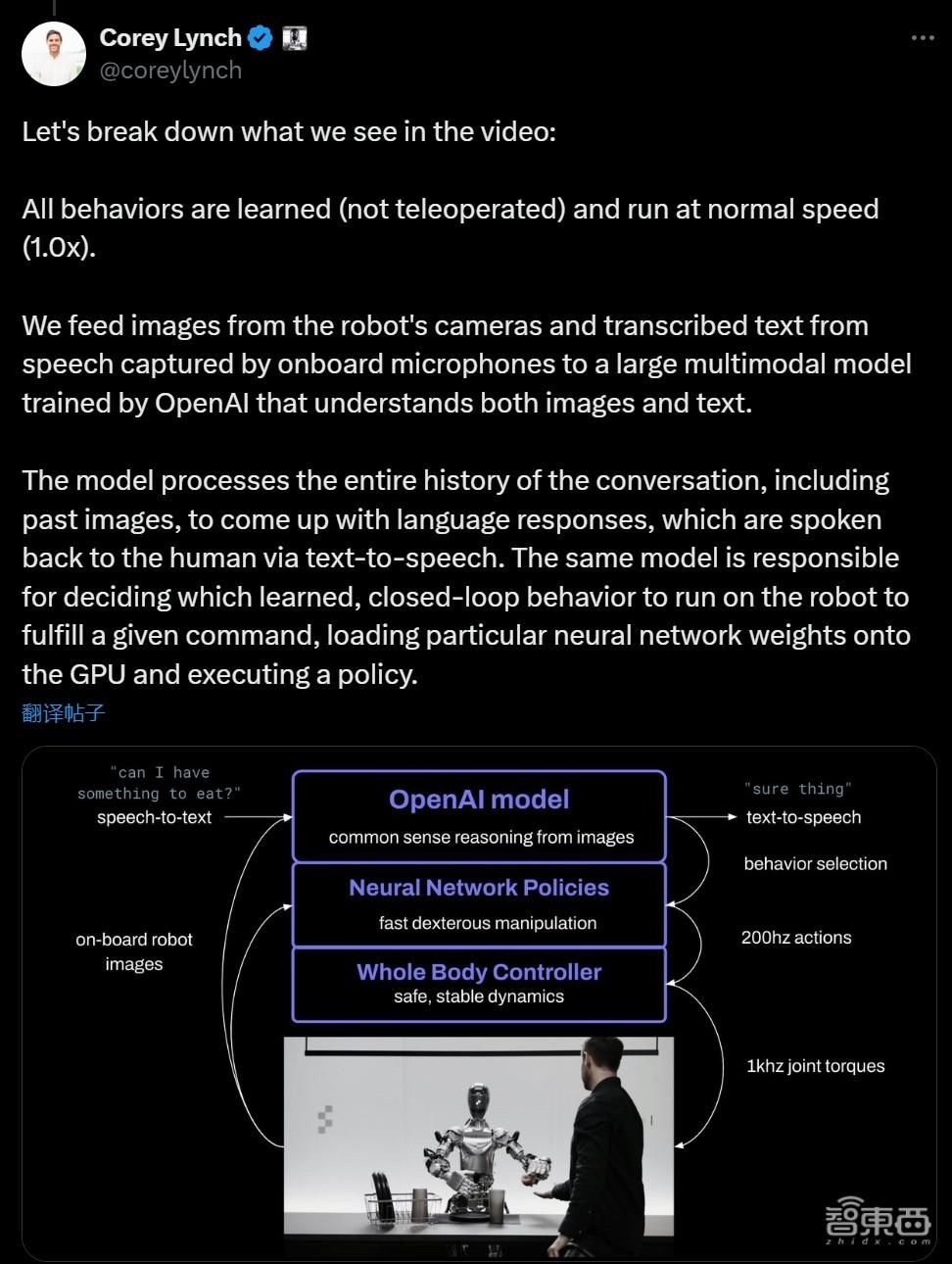

随后,Corey Lynch对视频内容进行了进一步技术拆解。以下是他技术拆解的全文:

Figure 01所有的行为都是学习得来的(而非遥控操作的),并以正常的速度(1倍速)运行。

我们将机器人摄像头的图像和机载麦克风捕获的语音转录文本输入到一个由OpenAI训练的大型多模态模型中,该模型会理解图像和文本。

该模型会处理整个对话的历史记录,包括过去的图像,以产生语言响应,这些响应通过文本到语音模型被人类听到。同一个模型负责决定在机器人上运行哪个学习到的闭环行为以完成给定的命令,将特定的神经网络权重加载到GPU并执行策略。

将Figure 01连接到一个大型预训练的多模态模型,赋予了它一些有趣的新能力。现在,Figure 01+ OpenAI可以:

1、描述它的周围环境。

2、在做决策时使用常识推理。例如,“桌子上的那个盘子和杯子可能接下来会放到晾碗架上”。

3、将模糊的、高级别的请求,如“我饿了”,转化为一些符合上下文的行为,如“把苹果递给这个人”。

4、用简单的英语描述为什么它执行了特定的动作。例如,“这是我能从桌子上提供给你的唯一可食用的物品”。

一个理解对话历史的大型预训练模型赋予了Figure 01强大的短期记忆。

考虑一下这个问题,“你能把它们放在那里吗?”“它们”指的是什么,而“那里”又在哪里?正确回答需要反思记忆的能力。

有了一个预训练模型分析对话的图像和文本历史,Figure 01很快就形成并执行了一个计划:

1)把杯子放在晾碗架上。

2)把盘子放在晾碗架上。

最后,让我们谈谈学习得来的低层级的(learned low-level)双手操作。

所有的行为都由神经网络视觉运动变换策略驱动,将像素直接映射到动作。这些网络以10Hz的频率接收机载图像,并以200Hz的频率生成24自由度的动作(手腕姿态和手指关节角度)。 这些动作作为高速率的”设定点”,供更高速率的全身控制器跟踪。 这是一个有用的关注点分离:

1、互联网预训练模型通过对图像和文本进行常识推理,提出高级计划。

2、学习到的视觉运动策略执行计划,执行难以手动指定的快速反应行为,比如在任何位置操作可变形的袋子。

3、同时,全身控制器确保安全稳定的动态。例如,保持平衡。

最后,Corey Lynch发表了自己的一些感受:

即使在几年前,我也会认为和一个能规划和执行自己的全学习行为的类人机器人(a humanoid robot while it plans and carries out its own fully learned behaviors)进行完整的对话是我们可能需要等待几十年才能看到的事情。显然,很多事情已经改变了。

在我看来,Figure现在是全世界将具身智能(embodied AI)规模化扩展最好的地方。

结语:AI大模型与机器人融合,加速具身智能技术迭代

在Figure发布的最新视频中,我们可以看到Figure的人形机器人与OpenAI大模型能力结合,完成了此前许多难以完成的“高难度动作”,机器人与人类的人机交互效果,再次向前迭代。

未来随着AI大模型与机器人更加深度的结合,机器人真正走向更广泛的商用、走向千家万户的进度也将提速,具身智能必将成为未来AI产业中的一条关键赛道。

友情提示

本站部分转载文章,皆来自互联网,仅供参考及分享,并不用于任何商业用途;版权归原作者所有,如涉及作品内容、版权和其他问题,请与本网联系,我们将在第一时间删除内容!

联系邮箱:1042463605@qq.com